2017 年,Google 的研究员们只想让呆板翻译变得更顺畅一点。他们并不知道,本身刚刚 在 arXiv 上上传的那篇论文,现实上是一份核兵器 的制造图纸。而最终按下发射按钮的,将是他们的竞争敌手 。在那一年,一篇名为《Att

2017 年,Google 的研究员们只想让呆板翻译变得更顺畅一点。他们并不知道,本身刚刚 在 arXiv 上上传的那篇论文,现实上是一份核兵器 的制造图纸。而最终按下发射按钮的,将是他们的竞争敌手 。在那一年,一篇名为《Attention Is All You Need》(你只需要注意力机制)的论文横空降生 。在那时,这看起来只是自然语言处置惩罚(NLP)领域的一次技能迭代;但站在今天回望,那是 AI 历史上的“古登堡时光 ”。 今天全部的顶流 AI——无论是 ChatCBT、Claude、Gemini 还是 Grok,它们的肉身固然属于差别的科技巨子 ,但灵魂深处的骨架倒是 一样的。这个骨架就是 Transformer。 为了明白为什么这篇论文是 Google 皇冠上最残暴 却也最棘手的明珠,我们需要把时钟拨回那个呆板还在患“健忘症”的年月 。 患有“健忘症”的模仿游戏在很长一段时光 里,人工智能在语言眼前像个笨拙的学渣。 早期的神经网络面临着一个致命的心理 缺点 :它们不明白“序列”。人类的语言本色 上是一条河道,上文决定下文,语境决定寄义。比如,“苹果”这个词,在“苹果很好吃”和“苹果股价大涨”中,代表着完全差别的器械 。 为了模拟这种过程,科学家创造 白 RNN(循环神经网络)。它的逻辑很符合直觉:像人一样,读完第一个词,记着它,带着记忆去读第二个词,再把两者的记忆融合传给第三个词。 但 RNN 很快撞上了一堵墙——“梯度消掉 ”(Vanishing Gradients)。  想象一下,你让一个学生背诵《红楼梦》,但他有一个怪病:每多读一句话,他对第一句话的记忆就衰减一半。读到第十句时,他已经彻底忘了开头在讲什么。这就是早期 AI 的逆境:随着句子变长,早期的输入旌旗灯号 在数学运算的层层传递中因为 不断相乘,最终变成了几乎为零的微弱反响 。 AI 没法处置惩罚长句子,更别提写文章了。它像是一个患有严峻短期记忆丧掉 症的病人,永远活在当下,永远没有已往。 被遗忘在 90 年月 的解药 历史老是 布满了幽默感。办理这个当代困难的钥匙,其实早在 1990 年月 就被打造出来了。 两位研究者 Hochreiter 和 Schmidhuber 提出了一种改进计划 :LSTM(是非期记忆网络)。简单来说,他们在神经网络里安装了几个“门控开关”(Gates)。这些开关负责决定哪些信息该逝世 记硬背(Keep),哪些废话该立即遗忘(Forget)。 这本来 是一个天才的计划。但在 90 年月 ,它是一场悲剧。 LSTM 布局太庞杂 了,当时的计算 机算力基本 跑不动它。它就像是一台计划精密的法拉利引擎,却被安装在了一辆木轮马车上。于是,LSTM 被荒凉在角落里吃灰了整整二十年。 直到 2010 年月 ,救世主降临——GPU 加速和大数据发作。 算力根本方法 的成熟,让这台法拉利引擎终于发出了轰鸣。LSTM 刹时回生 ,开始统治 NLP 领域。那几年,语音识别、文本生成,几乎全部的冲破 都以此为根本。但即使是回生 后的 LSTM,依然面临一个名为“瓶颈”的鬼魂 。 当时的翻译模子通常采用 Seq2Seq(序列到序列) 架构:先把一句中文输入进去,压缩 成一个固定长度的向量(Vector),再由解码器把它还原成英文。 把整部《战争与平静》压缩 成一张便当 贴巨细的信息摘要,且不能丢掉 任何细节——这在数学上几乎是不也许 的。 这种“固定向量”的瓶颈,让 Google 翻译在处置惩罚长难句时依然经常翻车,产出令人啼笑皆非的结果。 探照灯与暴力美学2014 年,事故开始起变革。研究职员决定给模子装上一盏“探照灯”——这就是注意力机制(Attention)的雏形。

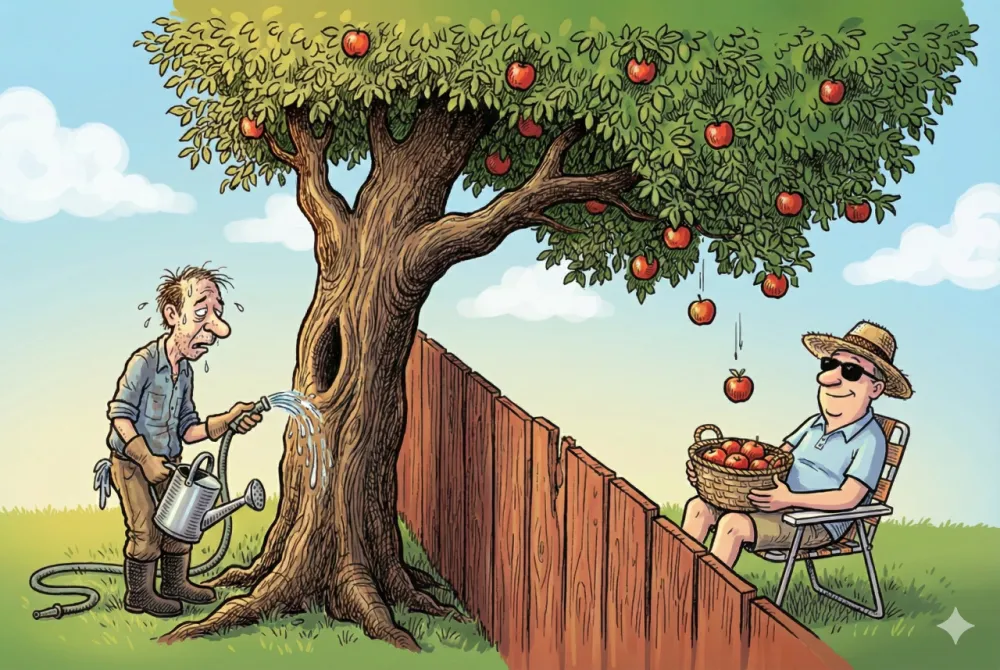

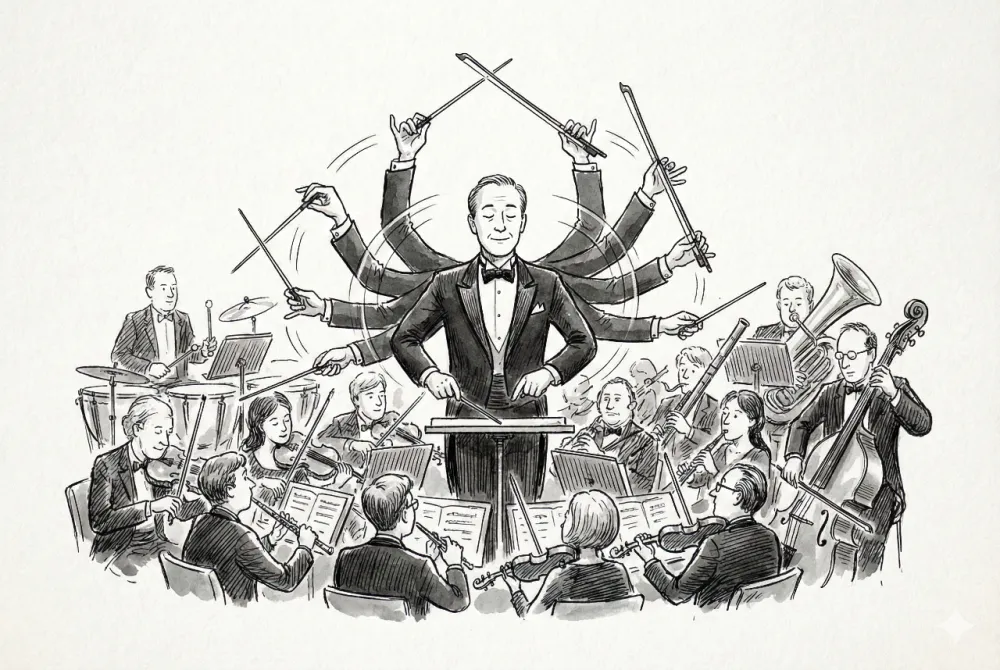

你也许 还记得也许 十年前的某一天,Google 翻译突然从“不成 用”变成了“惊人的精确”。那个刹时,就是 Google 在后台上线了带有注意力机制的神经翻译系统。 但这还不够。只要模子还依靠 RNN 的循环布局,它就必须“逐字阅读”。你不能并行计算 ,意味着训练大模子需要的时光 是天文数字。 于是,2017 年,Google Brain 团队做出了一个违背祖宗的决定:我们要彻底删掉循环。 这就是 Transformer 的身世 时光 。 如果不使用循环,怎么明白次序?Google 的答案 是:暴力并行,全局关注。 Transformer 不再像人类一样从左到右阅读。它像一个外星智慧,一眼看完备篇文章。通过自注意力机制(Self-Attention),它让文章中的每一个字,都能同时与文章中其他全部的字产生 联系,计算 出相互的相关性权重。 这就好比在一个闹热热烈繁华 的鸡尾酒会上,固然人声鼎沸,但你依然能刹时锁定这屋子里全部提到你名字的人,并创建连接。 这种架构带来了一个副产品 ,正是这个副产品 改变了天下:并行计算 本领。 因为它不需要等读完上一个字才气读下一个字,Transformer 答应我们在成千上万个 GPU 上同时训练模子。这种架构上的“解除封印”,让 AI 模子从“小作坊”直接进入了“重工业”期间。 没有 Transformer,就不也许 有后来参数量高达万亿级其余 GPT-4。速率,就是智能的入场券。 盗火者的反响故事的了局布满了宿命感。Google 创造 白 Transformer,最初只是想做一个更好的翻译软件。他们在这个架构上衍生出了 BERT,一个专注于“明白”的学霸模子。 而在大洋彼岸,OpenAI 却看中了 Transformer 的另一半潜力。他们专注于解码器(Decoder),对峙做“生成”,搞出了 GPT(Generative Pre-trained Transformer)系列。 起初 ,大家认为 这只是两条平行线:一个做明白,一个做生成。大家各司其职,为特定的任务训练特定的模子。直到 OpenAI 发现,只要把数据量堆得富足大,把 Transformer 堆得富足深,一种通用的、仿佛拥有灵魂的“智能”就会涌现。 Google 种下了树,全天下都在纳凉,而 OpenAI 摘走了最甜的那颗果实。 回看这段历史,你会发现并没有什么魔法 。所谓的 AI 革命,其实是一场长达 30 年的突围战。从 RNN 的逝世 记硬背,到 LSTM 的选择性记忆,再到 Transformer 的全局洞察,呆板终于学会了如何像我们一样——以致比我们更好地——去明白这个天下的上下文。 这篇 2017 年的论文,终结 了旧期间的 AI,也偶然中为 Google 的搜索帝国敲响了第一声警钟。但对于人类而言,这或许是我们第一次触遇到了真正的火种。 |

2025-05-03

2025-03-05

2025-02-26

2025-03-05

2025-02-26