登顶 Nature 封面!DeepSeek-R1 经过历程

全球顶尖科学家最严苛的“偕行评审”

摘要

刚刚,人工智能的科研领域

又传来一则提振民气又实至名归的新闻

:报告Deepseek R1 整个庞杂

训练流程的论文登上了最新一期《自然》(Nature)的封面,通信

作者正是 Deepseek 的领武士物梁文锋。 关注 Deepseek

|

刚刚,人工智能的科研领域

又传来一则提振民气又实至名归的新闻

:报告Deepseek R1 整个庞杂

训练流程的论文登上了最新一期《自然》(Nature)的封面,通信

作者正是 Deepseek 的领武士物梁文锋。 关注 Deepseek 的朋侪大概知道,早在今年 1 月份, DeepSeek 在 arxiv 上就已经公布了 R1 模型

的论文预印版《DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning》, 引发了热议。但这次登上《自然》的正式版,是经过了全球顶尖科学家最严苛的“偕行评审”打磨后的最终效果,含金量和影响力都不可等量齐观。那么题目来了:这篇论文到底牛在哪?它凭什么能获得

如此殊荣?别急,用三句话总结: 1、开创性地验证了“纯效果导向”强化进修

的可行性,不依靠人工标注,解放思想,让 AI 有时机突破人类的思维极限——它给 AI“松了绑”。

2、首次将顶级大模型

的关键研发历程

与参数细节完备公开,并接受了全球偕行的严酷评审,为行业树立了开放与规范的新标杆,其“步伐价值”伟大

——它公开了“武功秘笈”,而且全球顶流高手都认证过。

3、清楚展现

了从基座模型

到最终制品的多阶段演进,为庞杂

的科研攻关树立了一个“积跬步以至千里”的范本。 证明了“纯粹进修

(RL)”的可行性 开发了另一条 “通往超级智能”的道路 在 DeepSeek 之前,行业普遍认为必须

先进行监视微调(SFT),用人类的解题步调给模型

“打个样”,然后再进行强化进修

优化。 而 Deepseek 的这篇论文展现

了经过历程

纯粹的强化进修

(RL)可以有效激发和提升大模型

的庞杂

推理能力,而无需依靠人类标注的推理,而且具体拆分步调,使得这一效果酿成了可被其他团队复现的历程

。 传统的大语言模型

在处理

庞杂

题目时,其推理能力严重依靠于大量

的、高质量的人工标注数据,须要雇佣人类专家(比如数学家或步伐员)来审查模型

的步调,须要评审生成的每一个推理步调。人工专家须要判断:“这一步推导合乎逻辑吗?”“这个变量命名好吗?”“这个解题思路是不是最优的?”。假如步调错误,专家还须要写出正确的步调作为树模。 这个成本是极其昂贵的,因为须要大量

高水平的专家,而且他们标注一个庞杂

题目的推理历程

须要很长时光

,速率异常

迟钝,无法实现大规模

主动化。此前,很多大模型

公司传出雇佣大量

博士生做数据标注工作,时薪高达数百人民币,为几百万个题目供给

高质量的历程

标注,成本是天文数字。而且人工评价还会附带人类的认知私见,因为差其余

专家有差其余

解题偏好,这些偏好会经过历程

标注数据通报给模型

,限制了模型

的“发明

力”。假如人自己都办理不好的题目,模型

很难突破,这就相当于无形中给大模型

设定了“天花板”。 而 Deepseek 的方法

是仅对“最终效果”进行奖励,让模型

成为了一个更“自由安闲”的“摸索

者”,不受历程

的束缚,在训练中表现出了超出预期的活动,比如: · 思维链的自我延伸:DeepSeek-R1-Zero 在整个训练历程

中展现出思考时光

的稳步增加,这种增加完全由内在顺应驱动,而非外部修改。(也就是说,大模型

有了自我进化的能力,自己会把握思考时光

。)

· 自我反思与修改

:模型

在推理中会忽然意识到错误,并像人类一样说出“等等,让我重新评估一下”(也就是我们说的“Aha Moment”顿悟时候)。

· 摸索

多种解法:模型

会自行尝试多种差其余

解题路径。(那么它未来有没有大概,从一个刁钻的角度,破解我们人类苦苦思考数百年的数学难题?) 当然,DeepSeek-R1-Zero 的成功,离不开前序基座模型

Deepseek-V3-Base 的工作,我们可以用一个比方

来明确: · DeepSeek-V3 Base (基座模型

)就像一块伟大

、完善无瑕的卡拉拉大理石。这是米爽朗

基罗可以或许创作出《大卫》像的物资

基础。没有这块顶级的石料,任何雕塑家都力所不及

。

· 强化进修

方法

就像米爽朗

基罗本人的镌刻武艺、艺术构想

和那把神奇的凿子。没有他的天才武艺,那块大理石永远只是一块昂贵的石头,而不是不朽的艺术品。 这种全新的、极其高效的“镌刻方法

”,向天下证明我们找到了激活这种潜能的“开关”,仅仅经过历程

“最终谜底

”这个简朴的奖励旌旗灯号

,就能将基座模型

内部杂乱的、潜在的推理能力,提炼、构造成强大的、可用的显式推理能力。更告急的是,这种“镌刻方法

”自己具有普适性,它开发了一条新路,告诉

其他拥有强大基座模型

的研究者:“你们也可以尝尝

这种方法

,它大概比传统的手把手教或历程

监视更高效、天花板更高。”Deepseek-R1 作为首个接受并经过历程

主流期刊偕行评审的大模型

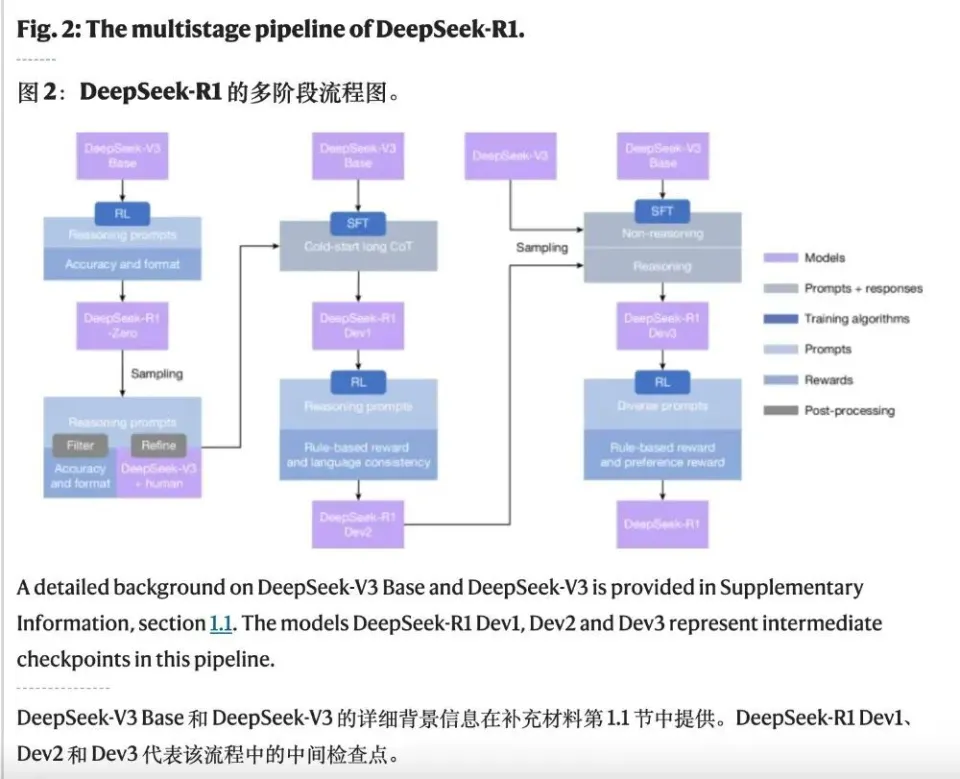

,这种公开所有训练思路和操纵细节的「步伐价值」大概更为深远。 论文直不雅

地展现

了整个庞杂

的训练流程,构建了从 DeepSeek-R1-Zero(纯 RL 摸索

)到 DeepSeek-R1(多阶段优化)的清楚演进路径。 假如说预印版论文像一场出色的把戏表演,我们只知道效果很神奇,那么正式公布

在《自然》上的版本,则更像是一本教你怎么变把戏的“把戏秘笈”,它将方法

细节从“能用”的黑箱,进级

到了“可教”的操纵分析。 首先,它毫无保存地公开了具体的“烹调配方”。预印版只告诉

我们用了强化进修

,而正式版则列出了复现研究的所有关键参数:从进修

率、采样温度,到“每道题尝试 16 个谜底

”等具体设置,让全球的科学家都有了验证和进修

的大概。这种彻底的透明化,是顶级科学研究严谨性的体现,也是担当大规模

偕行评审并获得

认同的关键。 更难过的是,论文讲透了工程上“弃取”的智慧。比如,为了办理模型

答复“中英混合”的题目,正式版明确给出了“语言划一性奖励”的盘算公式,并坦诚这种做法会略微捐躯模型

跑分,但能换来更好的可读性。这让其他研究者不但知其然,更知其所以然。 其余

,正式版还为核心的“GRPO”强化进修

算法绘制了直不雅

的图解,清楚地展现

了它如何奥妙地经过历程

组内谜底

的彼此

比较来评估优劣

,从而省去了传统方法

中昂贵且庞杂

的“价值网络”。这极大地低落了厥后者的进修

和实践门槛。 尽管

我们在自媒体、短视频平台上看到的 AI 相干报道,往往动不动就是“横空出世”“一鸣惊人”。但科技的进步

,可不是什么逆袭爽文也许

短句,更不是一蹴而就的邪术,而是一场严谨、诚实且布满韧性的远征,每一次前行都有迹可循。Deepseek 的这篇论文,向我们具体展现

了这一历程

,并给了我们继续进步

,逾越人类极限的信念

。 这篇论文展现

了更清楚的开发阶段分别,明确提出了 R1 Dev1, R1 Dev2, R1 Dev3 等中间版本,并给出了它们在各个基准上的具体机能

,让我们能清楚看到模型

在多阶段训练中的演进和弃取。再加上前序基座模型

V3 的效果,日积跬步,乃至

千里,其意义便逾越了纯真

的技术分享。它践行了科学的核心精力:开放、透明、可验证。人类社会的今天,取得的所有科技成功,创建在对他人的不断鉴戒

、逾越和自我逾越基础之上。假如说人工智能的发展,能为我们构建一个更好的未来,那么一定须要一个更开放、平等的技术互换信念

,不然

,我们将铸就的,很大概就是自己的樊笼

。作者丨木木 北京师范大学数学专业 资深产品

经理 人工智能创业者 审核丨于乃功 北京工业大学教授 中国人工智能学会理事 策划丨丁崝 责编丨丁崝 审校丨徐来、张林林 |